在AI界近期发生的一起风波中,Llama 4模型因被指在大型模型竞技场存在作弊行为而备受关注。这一事件导致Llama 4的排名从原先的第二位骤降至第三十二位,使其在竞技场中的位置变得不起眼。

据竞技场官方消息,Llama 4在首发时提交的版本名为“实验版”,实则是针对人类偏好进行优化的模型,具体名为Llama-4-Maverick-03-26-Experimental。这一行为被曝光后,Llama 4团队迅速采取了措施,重新上架了一个非特供版的模型,即HuggingFace开源版的同款Llama-4-Maverick-17B-128E-Instruct。这款模型拥有170亿激活参数和128个MoE专家的指令微调,但关于实验版具体如何针对人类偏好优化的细节,目前尚未公开。

尽管风波不断,但Llama 4模型在某些特定场景下仍展现出其独特的优势。有开发者分享经验称,在内存充足但内存带宽和计算能力较低的系统上,如使用CPU推理的x86服务器或在M3 Ultra Mac Studio上推理时,Llama 4 Maverick的速度比Mistral Small 3.1更快,且智能程度超过Mistral Large 2411和Command A。对于拥有288GB内存的双路至强服务器而言,Llama 4 Maverick更是能以不错的速度运行的最佳模型。

另一家Agent创业公司Composio在对Llama 4与DeepSeek v3进行详细对比后,也指出了Llama 4 Maverick的优点。他们认为,Llama 4 Maverick更便宜、更快速、工具性更强,适合基于实时交互的应用。尽管它并不完美,但如果meta能给予其更准确的定位,避免玩弄基准,它依然有其价值所在。

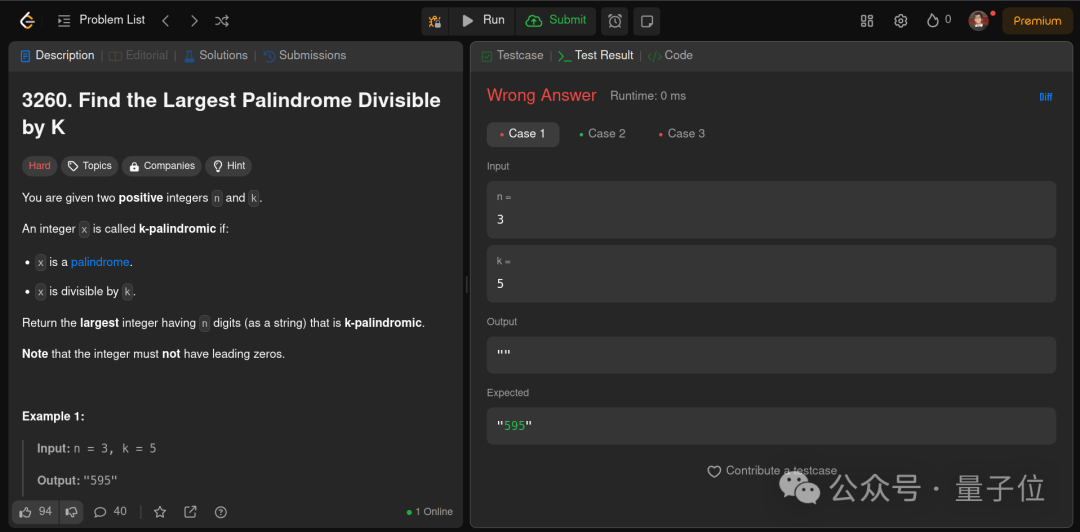

在具体测试中,Llama 4与DeepSeek v3的表现各有千秋。在代码能力方面,DeepSeek v3 0324的表现远优于Llama 4 Maverick。在一道人类通过率仅为15.2%的Leet Code题目上,Llama 4的代码连最初的几个测试用例都无法通过,而DeepSeek v3虽然也频繁超时,但通过的测试用例数量却多于Llama 4。然而,在常识推理方面,DeepSeek v3的表现又略胜一筹,它不仅给出了正确答案,还主动提供了可运行的代码示例。

在大型RAG任务中,Llama 4 Maverick展现出了其速度上的优势。在要求AI从100K个token的lorem ipsum输入中找出特定单词及其位置的任务中,Llama 4用16秒就找对了单词,虽然无法指出单词的位置或获取文档中的单词总数,但速度上已胜过DeepSeek V3。然而,在创作能力方面,两款模型都擅长写作,风格上略有不同,Llama 4 Maverick的写作风格更细致,而DeepSeek v3 0324的写作风格则更随意。

Llama 4虽然在竞技场风波中遭受了排名下滑的打击,但在特定场景和任务中仍展现出其独特的优势。未来,它能否重新赢得社区的信任并夺回其应有的地位,仍有待观察。