在人工智能界,一场围绕开源大模型Llama 4的风波正愈演愈烈。4月8日,备受瞩目的大模型评测平台Chatbot Arena发表了一份措辞严厉的声明,针对社群对meta新模型Llama 4排名的质疑,承诺将公开超过2000场真人对比测试的完整数据,并直接点名meta。

声明指出:“meta应当更明确地说明‘Llama-4-Maverick-03-26-Experimental’是一个针对人类偏好进行优化的定制化模型。我们正在更新排行榜策略,以防止此类混淆再次发生。”

这份声明不仅是对质疑的回应,更是对整个大模型行业的一次警示。Chatbot Arena由加州大学伯克利分校发起,以其独特的真人盲测机制,成为了最具行业影响力的大模型排行榜之一。开发者和AI爱好者在平台上用相同问题向两款模型提问,对比回答内容并投票打分,这种机制使得Chatbot Arena成为了外界最为信赖的评测平台。

当meta在4月5日发布其最新一代开源大模型Llama 4,并迅速冲上Chatbot Arena排行榜第二,仅次于Google发布的Gemini 2.5 Pro时,引发了广泛关注。然而,很快社区发现,这一版本是未公开的定制化调优实验模型,而非meta开源的正式版。争议由此爆发:这是否构成“刷榜”?Chatbot Arena是否被用作营销工具?meta为何如此操作?

更为糟糕的是,在一些官方未展示的专业基准测试中,Llama 4的表现也不尽如人意,几乎垫底。不少首批尝试的用户在Reddit等社交平台上表达失望,有人指出Llama 4在编程能力上的不足,并表示:“考虑到Llama-4-Maverick有402B的参数量,我为什么不直接使用DeepSeek-V3-0324呢?或者Qwen-QwQ-32B可能更合适,虽然性能相似,但它的参数量只有32B。”

这一连串事件让人不禁疑惑,曾经凭借Llama 2和Llama 3逐渐建立口碑的meta,为何在Llama 4上栽了跟头?时间回溯到4月5日,meta在官方博客上宣布Llama 4系列模型面向社区开源,包括Llama 4 Scout、Llama 4 Maverick以及仍在训练中的教师模型Llama 4 Behemoth,均首次采用混合专家(MoE)架构。

其中,最受关注的Maverick版本拥有128个专家,170亿活跃参数(总参数为4000亿),meta将其描述为“同类最佳的多模态模型”,强调其在多方面超过Gemini 2.0与GPT-4,在编码和推理方面比Deepseek 3.1更有竞争力。然而,Llama 4发布后不久,情况迅速恶化。首批用户对Llama 4的表现并不满意,尤其是在需要代码能力和严谨逻辑推理的场景中,Llama 4的表现并未兑现其超越GPT、DeepSeek的承诺。

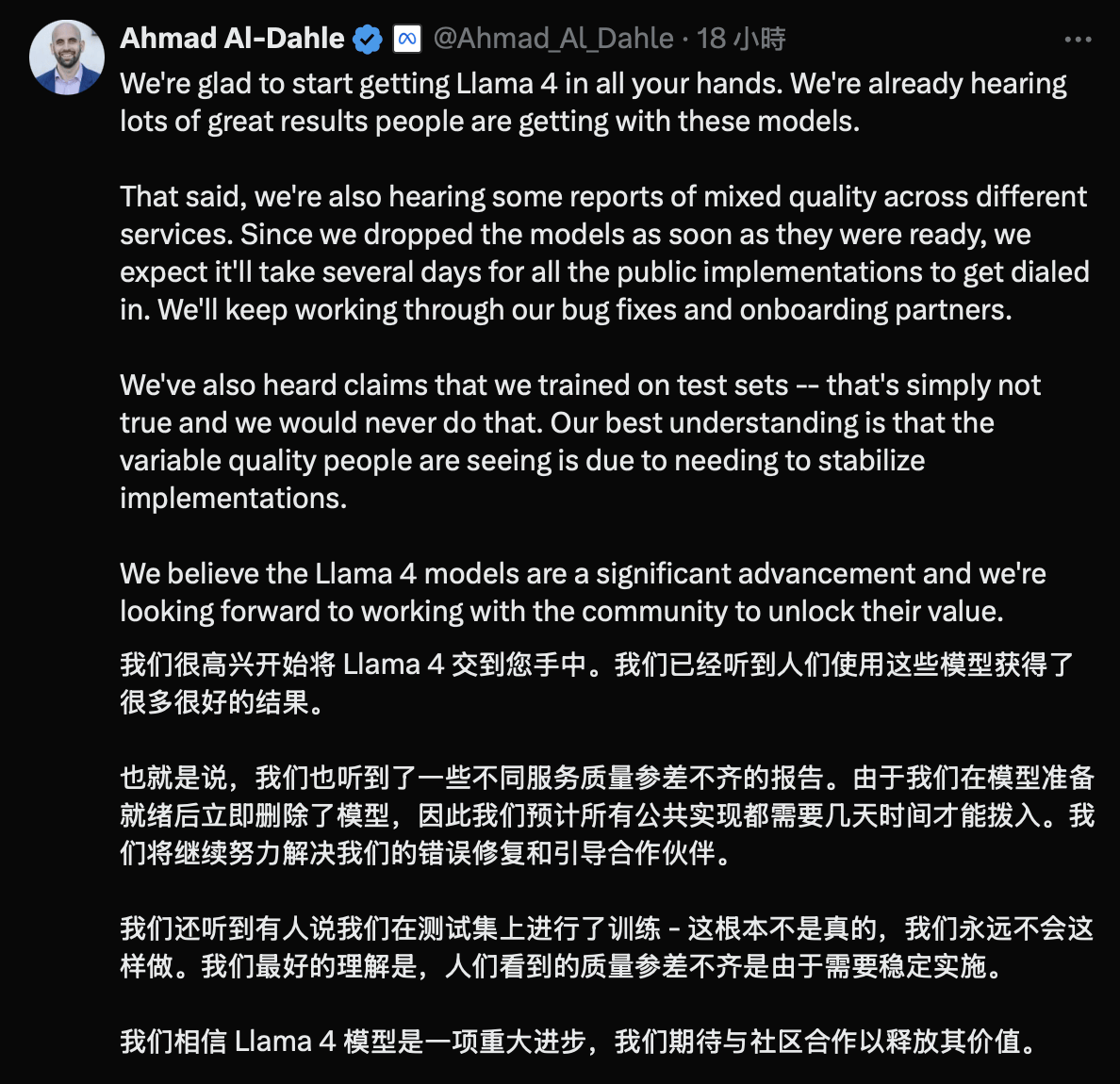

随着风评下滑,更严厉的质疑接踵而至:Llama 4是否使用了公开测试集进行训练?是否针对Chatbot Arena进行了针对性优化?这些质疑在技术社区迅速传播、发酵。尽管meta团队迅速出面澄清,包括负责meta GenAI的副总裁Ahmad Al-Dahle也在社交平台明确表示meta没有在测试集上训练Llama 4,但这些回应并未能完全平息外界的质疑。

事实上,无论是meta团队中的虞立成(Licheng Yu),还是Ahmad Al-Dahle,都在驳斥部分质疑的同时承认了Llama 4在性能上存在的问题。作为开源阵营中曾经“最有希望挑战OpenAI”的旗手,Llama 4原本承载着开发者与产业界的高度期待。然而,它却在发布一周内从“高光”跌入“信任危机”,成为大模型竞赛中一次罕见的口碑“滑铁卢”。

深入分析,Llama 4的问题不在于造假,而在于开源大模型竞争加剧下的失速。过去两年,meta凭借Llama 2和Llama 3逐步在开源模型市场上建立起领先地位。然而,到了Llama 4,情况已经发生了巨大变化,DeepSeek V3/R1的发布扭转了开源与闭源模型的差距,并大大加速了开源模型的发展速度。这让原本作为“开源领导者”的Llama面临更大的压力。在参数规模膨胀、架构复杂化的同时,Llama 4很可能没有留出足够的测试和改进时间,才导致发布后不稳定的性能表现。

meta在Llama 4的发布策略上也存在失误。Llama-4-Maverick-03-26-Experimental针对对话模式的优化本身无可厚非,但首发Chatbot Arena的目的却过于明显。这一特调版本是否牺牲了其他方面的性能,也引发了外界的猜测。